What is what you see? [Technology]

多くのデジタルカメラで、画像の輝度ヒストグラムの表示が可能です。また、RAW 現像ソフトウェアでは、輝度ヒストグラムを参照しながら、現像条件を決定します。

この表示されている輝度はどのような値なのでしょうか?

RAW には、画素が吸収した光子の量をデジタル変換した結果が記録されていると考えられます。私は単純なので、このデジタル値を 10 進法に変換した値だと思っていました。

ところが、そうではないことに、最近ようやく気が付きました。

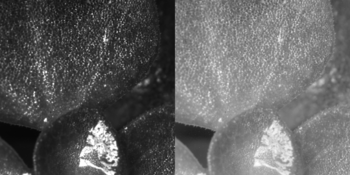

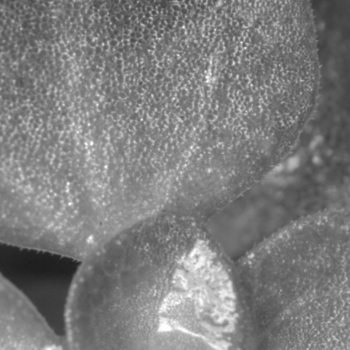

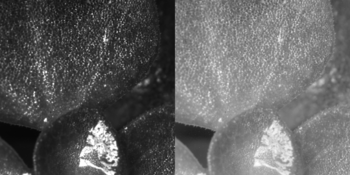

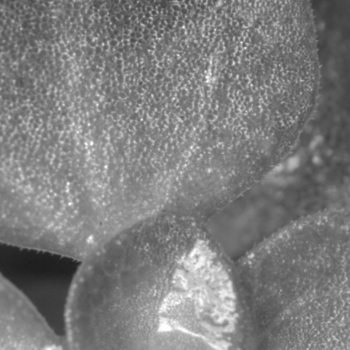

以下の画像をご覧ください。

DP3 Merrill の RAW を ImageJ という科学研究用画像処理ソフトウェアで現像した結果です。左はリニアスケールでの現像で、右はさらに対数変換した画像です。

以下の画像は、Sigma Photo Pro 6.5.3 で現像した結果です。

見た目は、ImageJ での対数変換画像とほぼ同じです。

SPP は現像時に輝度を対数圧縮するようです。DP3 Merrill は特殊な積層センサを積んでいますので、その特性に合わせた仕様かもしれません。

そこで、DP review で公開されている Leica M Monochrome (Typ 246) による撮影画像を使って、ACR と IJ による現像を比較しました。

KODAK グレースケール部の明部8段分を輝度でプロットしました。

左から Adobe Camera Raw (ACR)、IJ 対数変換、IJ リニアの現像です。

輝度の変化は、ACR と対数変換では一定ですが、リニアでは明部ほど大きくなります。KODAK グレースケールは印刷濃度が 1/3 EV 単位で変化しますので、リニア現像の数値が正しい結果です。

なぜ ACR や SPP は対数変換するのでしょうか?

現在の PC 用ディスプレイでは、入力値が 2.2 乗されて表示されます。したがって、RAW の輝度値を 2.2 を底とした対数値に変換してディスプレイに出力すれば、元の画像が表示されると期待できるためでしょう。

RAW 現像ソフトウェアが表示する輝度値は、対数変換だけでなく、デモザイク、色温度調整やノイズリダクションなどの様々な処理の結果です。そこに本当の値を期待することが、誤っているのでしょう。

この表示されている輝度はどのような値なのでしょうか?

RAW には、画素が吸収した光子の量をデジタル変換した結果が記録されていると考えられます。私は単純なので、このデジタル値を 10 進法に変換した値だと思っていました。

ところが、そうではないことに、最近ようやく気が付きました。

以下の画像をご覧ください。

DP3 Merrill の RAW を ImageJ という科学研究用画像処理ソフトウェアで現像した結果です。左はリニアスケールでの現像で、右はさらに対数変換した画像です。

以下の画像は、Sigma Photo Pro 6.5.3 で現像した結果です。

見た目は、ImageJ での対数変換画像とほぼ同じです。

SPP は現像時に輝度を対数圧縮するようです。DP3 Merrill は特殊な積層センサを積んでいますので、その特性に合わせた仕様かもしれません。

そこで、DP review で公開されている Leica M Monochrome (Typ 246) による撮影画像を使って、ACR と IJ による現像を比較しました。

KODAK グレースケール部の明部8段分を輝度でプロットしました。

左から Adobe Camera Raw (ACR)、IJ 対数変換、IJ リニアの現像です。

輝度の変化は、ACR と対数変換では一定ですが、リニアでは明部ほど大きくなります。KODAK グレースケールは印刷濃度が 1/3 EV 単位で変化しますので、リニア現像の数値が正しい結果です。

なぜ ACR や SPP は対数変換するのでしょうか?

現在の PC 用ディスプレイでは、入力値が 2.2 乗されて表示されます。したがって、RAW の輝度値を 2.2 を底とした対数値に変換してディスプレイに出力すれば、元の画像が表示されると期待できるためでしょう。

RAW 現像ソフトウェアが表示する輝度値は、対数変換だけでなく、デモザイク、色温度調整やノイズリダクションなどの様々な処理の結果です。そこに本当の値を期待することが、誤っているのでしょう。

Phase detection on an image sensor [Technology]

最近は多くのカメラで撮像面位相差検出AFが採用されています。

これまでの位相差検出AFは、DSLRで採用されてきた専用ユニットを使う方法が一般的でした。

その原理をニコンが分かりやすい動画で紹介していますので、以下のリンクからご覧ください。

高速で動く被写体も瞬時にピント合わせできる、最先端オートフォーカスシステム

簡単に説明すると、レンズの中心を通った光と周辺部を通った光の位置関係が、ジャストフォーカスを境に入れ替わることを利用しています。この方法は、ある一点のフォーカス状態を、光学系を組むことが出来れば様々な方向で同時に判定できます。

(注:ニコンの説明動画は、レンズの光軸側を通っている光をセパレータレンズで屈折させていませんが、これは明らかに誤りです。)

撮像面位相差検出AFでも、この位置関係の変化を利用してます。

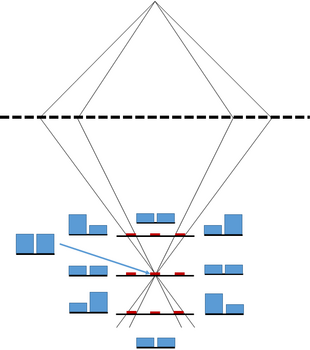

私の理解を図にまとめました。

点線が結像レンズ、図の上方が物体側、下方が結像面側です。

三つの赤線が載っている黒の実線は撮像面を、赤線は図の左右に分割された光検出素子を表しています。図示していませんが、分割された素子にはセパレータレンズを兼ねたマクロマイクロレンズが載っているとします。

撮像面が移動すると、結像面を境にして、結像レンズの周辺部を通った光が光検出素子に入射する角度が逆転します。その結果、水色の棒グラフで示したように、分割された素子への入射光強度も逆転します。また、中央の素子は、合焦時に最も明るくなります。このような現象を利用して撮像面での位相差を検出していますので、2個以上の分割素子がフォーカスポイントを挟んで配置されている必要があります。

キヤノンのDual Pixelでは2個の素子で1画素とし、他のメーカーは異なる部分を遮光した画素2個をセットにしています。ソニーはキヤノンと同様な構造も作っているようですが、詳細は分かりません。

説明図では分かりやすくするために光束を限定して示しましたが、実際には結像レンズは左右に分割されるだけで、素子への光入射角度はずっと広くなり、セットの素子間の入射光強度差はわずかになります。また、イメージサークル周辺部は、レンズの光学設計によっては入射角度が偏るため、位相差検出は困難になります。さらに、撮像センサには画像も投影されますので、その明暗は入射光強度に影響を与えます。

特許文献を見ると、私の説明のように強度の単純な比較ではなく、左側素子の強度変化パターンと右側素子の強度変化パターンを比較し、そのズレを使って測距する方法も開発されているようです。キヤノンがDPRAWとDPP4の組み合わせで実現した”ボケシフト”は、このズレを使った測距の応用でしょうね。

【追記 2016.12.24】

元記事中の”マクロレンズ”は”マイクロレンズ”の誤りでしたので、修正いたしました。

”像面位相差AF”が一般的ですが、”像面”では結像面と撮像面の区別がつきませんので、以後は”撮像面位相差検出AF”とします。

これまでの位相差検出AFは、DSLRで採用されてきた専用ユニットを使う方法が一般的でした。

その原理をニコンが分かりやすい動画で紹介していますので、以下のリンクからご覧ください。

高速で動く被写体も瞬時にピント合わせできる、最先端オートフォーカスシステム

簡単に説明すると、レンズの中心を通った光と周辺部を通った光の位置関係が、ジャストフォーカスを境に入れ替わることを利用しています。この方法は、ある一点のフォーカス状態を、光学系を組むことが出来れば様々な方向で同時に判定できます。

(注:ニコンの説明動画は、レンズの光軸側を通っている光をセパレータレンズで屈折させていませんが、これは明らかに誤りです。)

撮像面位相差検出AFでも、この位置関係の変化を利用してます。

私の理解を図にまとめました。

点線が結像レンズ、図の上方が物体側、下方が結像面側です。

三つの赤線が載っている黒の実線は撮像面を、赤線は図の左右に分割された光検出素子を表しています。図示していませんが、分割された素子にはセパレータレンズを兼ねた

撮像面が移動すると、結像面を境にして、結像レンズの周辺部を通った光が光検出素子に入射する角度が逆転します。その結果、水色の棒グラフで示したように、分割された素子への入射光強度も逆転します。また、中央の素子は、合焦時に最も明るくなります。このような現象を利用して撮像面での位相差を検出していますので、2個以上の分割素子がフォーカスポイントを挟んで配置されている必要があります。

キヤノンのDual Pixelでは2個の素子で1画素とし、他のメーカーは異なる部分を遮光した画素2個をセットにしています。ソニーはキヤノンと同様な構造も作っているようですが、詳細は分かりません。

説明図では分かりやすくするために光束を限定して示しましたが、実際には結像レンズは左右に分割されるだけで、素子への光入射角度はずっと広くなり、セットの素子間の入射光強度差はわずかになります。また、イメージサークル周辺部は、レンズの光学設計によっては入射角度が偏るため、位相差検出は困難になります。さらに、撮像センサには画像も投影されますので、その明暗は入射光強度に影響を与えます。

特許文献を見ると、私の説明のように強度の単純な比較ではなく、左側素子の強度変化パターンと右側素子の強度変化パターンを比較し、そのズレを使って測距する方法も開発されているようです。キヤノンがDPRAWとDPP4の組み合わせで実現した”ボケシフト”は、このズレを使った測距の応用でしょうね。

【追記 2016.12.24】

元記事中の”マクロレンズ”は”マイクロレンズ”の誤りでしたので、修正いたしました。

Recent image sensors are seemed to be equipped with multi-gain amp [Technology]

少し前に、Leica SL (Typ601)はマルチゲインアンプを搭載していると書きました。同じ記事のコメントで、D5も同様にマルチゲインアンプを搭載していると予想しました。

他の機種も気になり、Dpreviewが公開している露出補正データを見直したところ、最近の機種のセンサーはみなマルチゲインアンプを搭載しているようです。

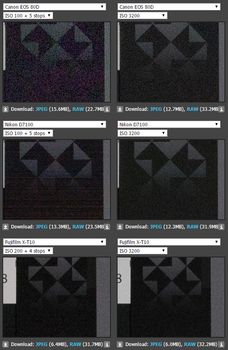

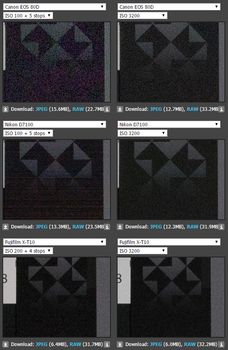

EOS 80D, D7100, X-T10の露出補正とそれに対応するISO感度での撮影画像です。

露出補正と感度設定が現像時の係数なら、左右は同じ画像になるはずですが、そうなっているのはX-T10だけです。

実は、比較可能な機種で左右が同じ画像になったのは、X-T10以外にはRX100/IVぐらいでした。X-T10のセンサーは比較的設計が古いソニーIMX071をベースとしていると思われますが、APS-C型よりも大きなソニー製センサーに関しては、それよりも設計の新しいものはADC前にマルチゲインアンプを搭載しているようです。

D7100の結果を見ると、東芝もマルチゲインと思われます。面白いことに、D7100の露出補正画像でみられる横縞が、D7200の画像にはありません。したがって、まったく同じセンサーではないと思われます。

キヤノンは最近までセンサー外にアンプとADCを置いていましたので、アンプのマルチゲイン化は比較的容易だったでしょう。80Dはデジタル出力と思われますが、マルチゲインアンプを実装しているようです。

最近のカメラでは、露出補正が感度設定の変更と同じではなくなっているようです。

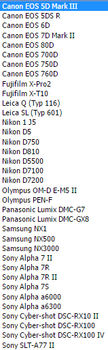

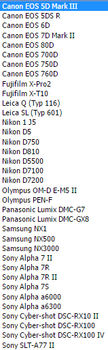

2016年4月12日現在で、Dpreviewのサイトで比較可能なカメラのリストです。

【2016/04/08 下線部を追加しました】

【2016/04/12 カメラリストを追加しました】

他の機種も気になり、Dpreviewが公開している露出補正データを見直したところ、最近の機種のセンサーはみなマルチゲインアンプを搭載しているようです。

EOS 80D, D7100, X-T10の露出補正とそれに対応するISO感度での撮影画像です。

露出補正と感度設定が現像時の係数なら、左右は同じ画像になるはずですが、そうなっているのはX-T10だけです。

実は、比較可能な機種で左右が同じ画像になったのは、X-T10以外にはRX100/IVぐらいでした。X-T10のセンサーは比較的設計が古いソニーIMX071をベースとしていると思われますが、APS-C型よりも大きなソニー製センサーに関しては、それよりも設計の新しいものはADC前にマルチゲインアンプを搭載しているようです。

D7100の結果を見ると、東芝もマルチゲインと思われます。面白いことに、D7100の露出補正画像でみられる横縞が、D7200の画像にはありません。したがって、まったく同じセンサーではないと思われます。

キヤノンは最近までセンサー外にアンプとADCを置いていましたので、アンプのマルチゲイン化は比較的容易だったでしょう。80Dはデジタル出力と思われますが、マルチゲインアンプを実装しているようです。

最近のカメラでは、露出補正が感度設定の変更と同じではなくなっているようです。

2016年4月12日現在で、Dpreviewのサイトで比較可能なカメラのリストです。

【2016/04/08 下線部を追加しました】

【2016/04/12 カメラリストを追加しました】

Panasonic improves two image sensor technology, Organic-Photoconductive-Film CMOS and APD-CMOS [Technology]

パナソニックが、二つのイメージセンサー技術を発表しました。

有機薄膜を用いた広ダイナミックレンジCMOSセンサー技術とグローバルシャッター技術、そしてアバランシェ・ブレークダウンを利用した増感CMOSセンサー技術です。

富士フイルムの素材を用いた有機光電変換膜の方が注目を集めているようです。

プレスリリースに掲載された模式図を見ると、BSIのシリコンPDセンサーと基本構造は同じです。簡単には、キヤノンのDual Pixel CMOSをBSIにして、組になる画素の受光面積比を1:10にした構造と言えるでしょう。また、配線図は、スーパーCCDハニカムSRIIを彷彿とさせますね。

個人的に驚いたのは、アバランシェ・ブレークダウンを利用したセンサーです。「2016 International Solid-State Circuits Conference」では、「A 1280×720 Single-Photon-Detecting Image Sensor with 100dB Dynamic Range Using a Sensitivity-Boosting Technique. M. Mori, Y. Sakata, M. Usuda, S. Yamahira, S. Kasuga, Y. Hirose, Y. Kato, T. Tanaka Panasonic, Nagaokakyo, Japan」として発表しています。

アブストラクトがまだ公開されていませんので素材などの詳細が分かりませんが、NHKがパナソニックと共同研究中で、Imagerマニアさんが2014年時点で3年後(2017年?)の実用化を目指していると報告された結晶セレンを使ったセンサーだと思われます。

研究段階から実用化へと開発が進んだのでしょう。実用的な感度を持つSuper35 8Kセンサーも夢ではありませんね。

有機薄膜を用いた広ダイナミックレンジCMOSセンサー技術とグローバルシャッター技術、そしてアバランシェ・ブレークダウンを利用した増感CMOSセンサー技術です。

富士フイルムの素材を用いた有機光電変換膜の方が注目を集めているようです。

プレスリリースに掲載された模式図を見ると、BSIのシリコンPDセンサーと基本構造は同じです。簡単には、キヤノンのDual Pixel CMOSをBSIにして、組になる画素の受光面積比を1:10にした構造と言えるでしょう。また、配線図は、スーパーCCDハニカムSRIIを彷彿とさせますね。

個人的に驚いたのは、アバランシェ・ブレークダウンを利用したセンサーです。「2016 International Solid-State Circuits Conference」では、「A 1280×720 Single-Photon-Detecting Image Sensor with 100dB Dynamic Range Using a Sensitivity-Boosting Technique. M. Mori, Y. Sakata, M. Usuda, S. Yamahira, S. Kasuga, Y. Hirose, Y. Kato, T. Tanaka Panasonic, Nagaokakyo, Japan」として発表しています。

アブストラクトがまだ公開されていませんので素材などの詳細が分かりませんが、NHKがパナソニックと共同研究中で、Imagerマニアさんが2014年時点で3年後(2017年?)の実用化を目指していると報告された結晶セレンを使ったセンサーだと思われます。

研究段階から実用化へと開発が進んだのでしょう。実用的な感度を持つSuper35 8Kセンサーも夢ではありませんね。

Mamiya digital imaging is acquired by Phase One for an integral operation between XF camera system and IQ digital back. [Technology]

Phase Oneが、既に45%の株式を保有していたマミヤ・デジタル・イメージング(MDI)から光学事業を買収・統合しました。

Phase Oneのカメラボディとレンズの製造はMDIが担っていましたが、同一会社となることでIQシリーズとの連携がより密接になるのでしょう。

Phase Oneの最新カメラボディであるXFは、Honeybee Autofocus PlathomeというウェストレベルファインダーでもAFとAEが可能な測光システムを内蔵しています。AF光学系が露光計も兼ねてるようで、個人的にそのしくみに興味があったのですが、技術情報が公開されていませんでした。

前期のPhase OneによるMDI買収のニュースを知った際に、何となくHoneybee Autofocus Plathomeをキーワードに画像検索したところ、ヒントを与えてくれるサイトが見つかりました。

この画像をご覧下さい。

通常のDSLRではサブミラーで反射した像は位相差検出素子に入射しますが、Honeybee Autofocus Plathomeでは1M画素のイメージセンサー上に結像させるようです。多分、このイメージセンサーには位相差検出用のマスクとカラーフィルターパターンの両方があり、それぞれAFとAEに使われているのでしょう。画素数が1Mと少ないのは、フレームレートと感度を上げるためでしょうね。

この方法そのものは誰でも思いつくので特許にはならないでしょうから、35mmフルフレームカメラでも採用し、ファインダー交換を実現して欲しいです。

Phase Oneのカメラボディとレンズの製造はMDIが担っていましたが、同一会社となることでIQシリーズとの連携がより密接になるのでしょう。

Phase Oneの最新カメラボディであるXFは、Honeybee Autofocus PlathomeというウェストレベルファインダーでもAFとAEが可能な測光システムを内蔵しています。AF光学系が露光計も兼ねてるようで、個人的にそのしくみに興味があったのですが、技術情報が公開されていませんでした。

前期のPhase OneによるMDI買収のニュースを知った際に、何となくHoneybee Autofocus Plathomeをキーワードに画像検索したところ、ヒントを与えてくれるサイトが見つかりました。

この画像をご覧下さい。

通常のDSLRではサブミラーで反射した像は位相差検出素子に入射しますが、Honeybee Autofocus Plathomeでは1M画素のイメージセンサー上に結像させるようです。多分、このイメージセンサーには位相差検出用のマスクとカラーフィルターパターンの両方があり、それぞれAFとAEに使われているのでしょう。画素数が1Mと少ないのは、フレームレートと感度を上げるためでしょうね。

この方法そのものは誰でも思いつくので特許にはならないでしょうから、35mmフルフレームカメラでも採用し、ファインダー交換を実現して欲しいです。

Creation of high-frequency components over the Nyquist frequency? [Technology]

富士通のスマホ「arrows NX F-02H」には「超解像技術」が組み込まれているそうです。

技術を開発した工学院大学の合志清一教授は、現在の4Kテレビに搭載されている超解像について「この超解像は嘘八百」とまでおっしゃっているようなので、合志教授の超解像技術について調べてみました。

合志教授の「超解像技術」の原理は公開されていますので、興味のある方はダウンロードしてご覧下さい。

合志教授は、自身が開発した技術はナイキスト周波数を超える高周波情報を作りだすので超解像だと説明しているようです。しかし、論文のFig.6を見ると、行っているのは拡大した画像からのハイパスフィルターを用いたエッジ抽出とその強調処理であることが分かります。強調処理によって変化が急峻になり、その結果として元情報にはない高周波が付加されます。この高周波はナイキスト周波数よりも短い波長を含むので、周波数成分としては最終画像で超解像が達成されたことになります。

ほぼ同じ事は既存の画像処理ソフトウェアで可能です。まず画像をバイキュービック法で拡大します。バイキュービック法は3次式で補間するので、元画像にはない高周波成分が少し付加されます。更にこの画像をアンシャープマスク処理します。アンシャープマスクはエッジの強調なので、バイキュービック法で付加された高周波成分が増幅されます。結果として、周波数成分としては超解像の画像が得られます。

私の理解では、合志教授の方法は周波数成分に限れば超解像ということは可能ですが、実際にはエッジの強調処理を行っているだけです。「arrows NX F-02H」を売るためのセールストークなのでしょうが、ちょっとやり過ぎと感じました。

技術を開発した工学院大学の合志清一教授は、現在の4Kテレビに搭載されている超解像について「この超解像は嘘八百」とまでおっしゃっているようなので、合志教授の超解像技術について調べてみました。

合志教授の「超解像技術」の原理は公開されていますので、興味のある方はダウンロードしてご覧下さい。

合志教授は、自身が開発した技術はナイキスト周波数を超える高周波情報を作りだすので超解像だと説明しているようです。しかし、論文のFig.6を見ると、行っているのは拡大した画像からのハイパスフィルターを用いたエッジ抽出とその強調処理であることが分かります。強調処理によって変化が急峻になり、その結果として元情報にはない高周波が付加されます。この高周波はナイキスト周波数よりも短い波長を含むので、周波数成分としては最終画像で超解像が達成されたことになります。

ほぼ同じ事は既存の画像処理ソフトウェアで可能です。まず画像をバイキュービック法で拡大します。バイキュービック法は3次式で補間するので、元画像にはない高周波成分が少し付加されます。更にこの画像をアンシャープマスク処理します。アンシャープマスクはエッジの強調なので、バイキュービック法で付加された高周波成分が増幅されます。結果として、周波数成分としては超解像の画像が得られます。

私の理解では、合志教授の方法は周波数成分に限れば超解像ということは可能ですが、実際にはエッジの強調処理を行っているだけです。「arrows NX F-02H」を売るためのセールストークなのでしょうが、ちょっとやり過ぎと感じました。

The short flange distance prevents a performance-improvement of ultra wide angle lenses. [Technology]

ilovehatephotographyにZeissへのインタビューが掲載されています。

超広角FEレンズに関する質問へのZeissの回答に興味深い内容がありましたので、以下に引用します。

"This short flange distance make it difficult when developing the lenses as the sharpness on the edges and the vignetting tend to be too important."

高性能レンズは、焦点距離に関わらずそれなりのバックフォーカスが必要なようです。

FEレンズの設計では、センサー近くの小さなEマウントが邪魔でしょうね。

超広角FEレンズに関する質問へのZeissの回答に興味深い内容がありましたので、以下に引用します。

"This short flange distance make it difficult when developing the lenses as the sharpness on the edges and the vignetting tend to be too important."

高性能レンズは、焦点距離に関わらずそれなりのバックフォーカスが必要なようです。

FEレンズの設計では、センサー近くの小さなEマウントが邪魔でしょうね。

Where is the HP finder gone? [Technology]

私は、乱視で近視に加えて最近は老眼も始まったため、日常生活に眼鏡が必須です。

しかし、眼鏡をかけたまま35mmフルフレーム機のファインダーを覗くと、どれも視野がけられてしまいます。APS-C機でも、ファインダー倍率の大きな機種ではけられてしまいます。どうも、設計アイポイント位置に眼の瞳が届いていないようです。

覗いた機種の仕様から推定すると、35mmフルフレーム換算で倍率が0.77倍でアイポイント長が23mmのファインダー光学系(X-T1のEVFです)なら、私の場合はファインダー視野がけられないようです。アイポイント長が短くなると、けられない倍率もいっそう低くなります。D5100のファインダーの倍率は換算0.52倍ですが、アイポイント長が18mmと短いため、けられないギリギリです。

Nikon F3は、0.75倍で25mmのDE-3や0.6倍で60mmのDA-2を選ぶことができました。Pentax LXでも0.55倍で60mmになるFB-1 + FC-1という組合せがありました。なぜ現在は、DE-3のような仕様のOVFを持つDSLRを選択できないのでしょうか。

メーカーは、ファインダー倍率が下がるのでスペックとしての訴求力が弱いと考えているのでしょう。また、ファインダー光学系の開発費用が少ないのかもしれません。しかし、ファインダー倍率が高くても、視野がけられてしまうのでは実用的に意味がありませんね。

しかし、眼鏡をかけたまま35mmフルフレーム機のファインダーを覗くと、どれも視野がけられてしまいます。APS-C機でも、ファインダー倍率の大きな機種ではけられてしまいます。どうも、設計アイポイント位置に眼の瞳が届いていないようです。

覗いた機種の仕様から推定すると、35mmフルフレーム換算で倍率が0.77倍でアイポイント長が23mmのファインダー光学系(X-T1のEVFです)なら、私の場合はファインダー視野がけられないようです。アイポイント長が短くなると、けられない倍率もいっそう低くなります。D5100のファインダーの倍率は換算0.52倍ですが、アイポイント長が18mmと短いため、けられないギリギリです。

Nikon F3は、0.75倍で25mmのDE-3や0.6倍で60mmのDA-2を選ぶことができました。Pentax LXでも0.55倍で60mmになるFB-1 + FC-1という組合せがありました。なぜ現在は、DE-3のような仕様のOVFを持つDSLRを選択できないのでしょうか。

メーカーは、ファインダー倍率が下がるのでスペックとしての訴求力が弱いと考えているのでしょう。また、ファインダー光学系の開発費用が少ないのかもしれません。しかし、ファインダー倍率が高くても、視野がけられてしまうのでは実用的に意味がありませんね。

Who does really need the sensor with 250M pixels of Canon? [Technology]

キヤノンが、2億5千万画素のAPS-H型センサーを開発したと発表しました。

画素数には驚かされますが、ピクセルピッチは1.6 umでスマホに搭載されているセンサーよりも大きく、読み出し速度はNHKとForzaが開発した35mm フルフレーム型1億3千万画素センサーの1/6です。

BSIとはされていないのでFSIとすると、この画素ピッチでは開口率が小さく、センサーの実行感度は高くないでしょうね。

画素数以外に売りの無いセンサーで、開発発表のニュースリリースを出すほどの価値があるとは思えません。

何か社内的な事情があったのかなと勘ぐってしまいました。

画素数には驚かされますが、ピクセルピッチは1.6 umでスマホに搭載されているセンサーよりも大きく、読み出し速度はNHKとForzaが開発した35mm フルフレーム型1億3千万画素センサーの1/6です。

BSIとはされていないのでFSIとすると、この画素ピッチでは開口率が小さく、センサーの実行感度は高くないでしょうね。

画素数以外に売りの無いセンサーで、開発発表のニュースリリースを出すほどの価値があるとは思えません。

何か社内的な事情があったのかなと勘ぐってしまいました。

X-Trans CMOS and also II sensors seem to be based on Sony IMX071 [Technology]

デジカメInfoに、富士フイルム、パナソニックと東芝の三社がセンサーを開発しているとの情報が掲載されています。

その情報では、富士フイルムのAPS-C型X-Trans CMOSセンサーはソニー製とされています。私は東芝製と思っていたのですが、何の証拠もありません。富士フイルムのホームページには、X-Trans CMOSセンサーの画像が公開されています。そこで、画素数が対応するソニーのAPS-C型センサー IMX071と見比べてみました。

リンク先の画像をご覧ください。

X-T1のセンサーです。

IMX071です。

画像を重ねると、センサーからパッケージへの配線パターンが完全に一致しました。

APS-C型のX-Trans CMOS無印とIIは、共にソニーIMX071のカスタマイズ品でしょう。

センサー自体の改良も行われているのでしょうが、IMX071はすごいセンサーだと思います。

その情報では、富士フイルムのAPS-C型X-Trans CMOSセンサーはソニー製とされています。私は東芝製と思っていたのですが、何の証拠もありません。富士フイルムのホームページには、X-Trans CMOSセンサーの画像が公開されています。そこで、画素数が対応するソニーのAPS-C型センサー IMX071と見比べてみました。

リンク先の画像をご覧ください。

X-T1のセンサーです。

IMX071です。

画像を重ねると、センサーからパッケージへの配線パターンが完全に一致しました。

APS-C型のX-Trans CMOS無印とIIは、共にソニーIMX071のカスタマイズ品でしょう。

センサー自体の改良も行われているのでしょうが、IMX071はすごいセンサーだと思います。